Datemi un algoritmo e vi solleverò il mondo!

Archimede di Siracusa avrebbe potuto enunciare la frase nel titolo, senza nulla togliere alla sua dichiarazione storica sull’effetto della leva, se avesse potuto vivere nella nostra epoca attuale e rendersi così conto che sono proprio gli algoritmi che governano la maggior parte delle nostre attività quotidiane, governando il mondo.

Il nome “algoritmo” oggi può spaventare o generare eccitazione; in alcuni desta preoccupazione e in altri euforia di potere; è in grado di sollevare sentimenti contrastanti ma in definitiva la sua evoluzione ha sempre seguito quella dell’uomo stesso.

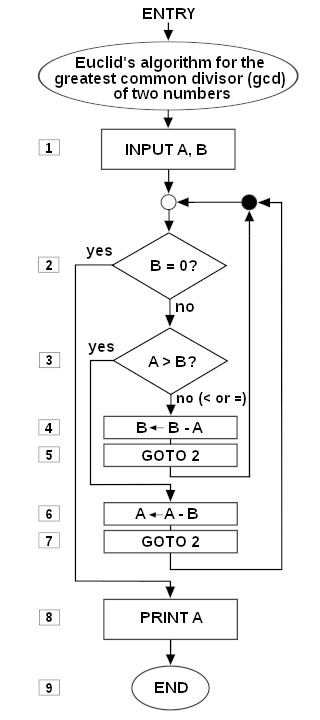

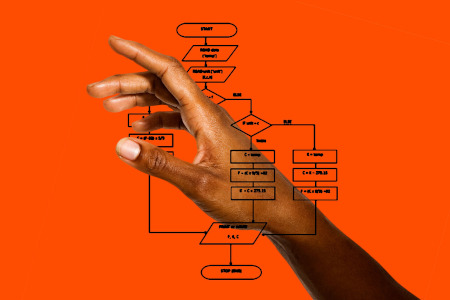

La definizione più generale del termine “algoritmo” è quella di una sequenza di istruzioni le quali – dato uno stato iniziale e le condizioni di ingresso – descrive una progressione di stati finiti ed elementari la cui esecuzione porta alla realizzazione di una condizione finale. Poichè il termine deriva dal matematico arabo Muḥammad ibn Mūsa del 9° sec., si è poi sempre voluta intendere la sua definizione come “…una sequenza matematica di calcolo…”. Tuttavia, se valutiamo il significato di algoritmo nella sua accezione più generale, anche la ricetta della pasta alla carbonara può essere intesa come un algoritmo. Lo stato iniziale è rappresentato dal banco vuoto della cucina, le condizioni di ingresso sono i vari ingredienti, la sequenza di stati finiti descrive la procedura di realizzazione, mentre la condizione finale è rappresentata dal piatto fumante e pronto per la tavola.

Gli algoritmi, in definitiva, sono istruzioni per risolvere un problema o realizzare una funzione. Le ricette sono algoritmi, così come le equazioni matematiche, il codice del computer, internet vive su algoritmi e tutte le ricerche online sono effettuate tramite il loro ausilio. Le applicazioni degli smartphone sono collezioni di algoritmi, i sistemi di localizzazione conducono le persone dal punto A al punto B attraverso di essi. L’intelligenza artificiale (AI) non è altro che una raccolta di algoritmi. Stanno ora emergendo anche algoritmi di autoapprendimento e autoprogrammazione, così da ipotizzare – senza ricorrere alla narrativa distopica – che sarà possibile in futuro che gli algoritmi stessi potranno scrivere e inventare molti (se non la maggior parte) dei nuovi algoritmi.

Gli algoritmi sono spesso strumenti eleganti e incredibilmente utili per svolgere attività comuni. Sono per lo più aiuti invisibili, che affiancano le attività umane in modi sempre più incredibili. Tuttavia, a volte l’applicazione di algoritmi creati con apparenti buone intenzioni, può portare a conseguenze indesiderate.

***

Storicamente, gli algoritmi non sono affatto un fenomeno nuovo: venivano infatti usati dai matematici Babilonesi per effettuare le divisioni, dai Greci con il noto “crivello di Eratostene” per ricavare i numeri primi, da Euclide per la ricerca del massimo comun divisore, e così via fino alla macchina di Alan Turing nel 1936 e oltre. Tuttavia, l’attuale interesse per gli algoritmi è oggi dovuto all’enorme quantità di dati generati dai sistemi Big Data (telecamere, tracciamento internet, transazioni bancarie) e alla necessità di elaborarli e comprenderli: sono ora perfettamente integrati nella nostra vita quotidiana.

In definitiva, però, l’algoritmo svolge per nostro compito attività banali e ripetitive (spesso in modo migliore e senza errori), facendo risparmiare tempo e denaro. Il problema però non è rappresentato dagli algoritmi in sé, piuttosto dal modo in cui vengono utilizzati e la riservatezza dei dati trattati.

L’area di maggiore preoccupazione è rappresentata da quella in cui operano i cosiddetti “algoritmi predittivi” usati nei campi delle scienze sociali o finanziarie, dove c’è minor comprensione di quello che dovrebbe essere il modello e il risultato, e dove operano in un ambiente molto dinamico. Uno scienziato potrebbe impiegare anni per validare il proprio algoritmo sulla sua ricerca scientifica, mentre un trader finanziario o un’impresa commerciale che opera sulle tendenze dei cittadini ha solo pochi giorni per farlo, in un ambiente – tra l’altro – molto “volatile”.

L’area di maggiore preoccupazione è rappresentata da quella in cui operano i cosidetti “algoritmi predittivi”.

La ricerca sull’etica degli algoritmi è cresciuta notevolmente negli ultimi dieci anni. Accanto allo sviluppo esponenziale e all’applicazione di algoritmi di apprendimento automatico, sono stati proposti nuovi problemi etici e soluzioni relative al loro uso onnipresente nella società. Pochi mesi fa (Gennaio 2021) è stato pubblicato uno studio di “AI & Society” dal titolo “The ethics of algorithms: key problems and solutions” (A. Tsamados, N. Aggarwal, et alia), con l’obiettivo di contribuire al dibattito sull’identificazione e l’analisi delle implicazioni etiche degli algoritmi, fornire un’analisi aggiornata delle preoccupazioni epistemiche e normative e offrire una guida utilizzabile per la governance della progettazione, sviluppo e implementazione degli algoritmi.

Nell’articolo “Snowden: il prezzo del gioco tecnologico” abbiamo evidenziato come l’uso improprio dei dati attraverso algoritmi realizzati con pochi scrupoli abbia consentito alla CIA e all’NSA – sotto l’apparente “ombrello” della sicurezza nazionale, – di spiare e raccogliere dati da qualunque mezzo elettronico impiegato da chiunque in ogni Paese del mondo. Da quando si è ribaltato il rapporto tra uomo e tecnica, da quando – cioè – il soggetto della storia si è spostato dall’uomo alla tecnica relegando l’essere umano a “funzionario” degli apparati tecnici a cui appartiene (cit U. Galimberti) il mondo è travolto da uno sconcertante e incontrollato tsunami dalle pericolose conseguenze.

Nell’articolo “Snowden: il prezzo del gioco tecnologico” abbiamo evidenziato come l’uso improprio dei dati attraverso algoritmi realizzati con pochi scrupoli abbia consentito alla CIA e all’NSA – sotto l’apparente “ombrello” della sicurezza nazionale, – di spiare e raccogliere dati da qualunque mezzo elettronico impiegato da chiunque in ogni Paese del mondo. Da quando si è ribaltato il rapporto tra uomo e tecnica, da quando – cioè – il soggetto della storia si è spostato dall’uomo alla tecnica relegando l’essere umano a “funzionario” degli apparati tecnici a cui appartiene (cit U. Galimberti) il mondo è travolto da uno sconcertante e incontrollato tsunami dalle pericolose conseguenze.

Le macchine “intelligenti” fanno ormai parte delle nostre vite. Aiutano i medici a diagnosticare le malattie, inviano le forze dell’ordine a catturare i criminali e preselezionano i candidati idonei per i dipartimenti delle risorse umane. Nelle società dell’informazione, le operazioni, le decisioni e le scelte precedentemente lasciate all’uomo sono sempre più delegate ad algoritmi, che possono consigliare, se non decidere, su come i dati dovrebbero essere interpretati e quali azioni dovrebbero essere intraprese di conseguenza. Sempre più spesso, gli algoritmi mediano i processi sociali, le transazioni commerciali, le decisioni governative e il modo in cui percepiamo, comprendiamo e interagiamo tra di noi e con l’ambiente. Le lacune tra la progettazione e il funzionamento degli algoritmi e la nostra comprensione delle loro implicazioni etiche possono avere gravi conseguenze che interessano sia gli individui che i gruppi di intere società.

Occorre perciò, oggi più che mai, rivalutare e riconsiderare con grande attenzione il rapporto tra essere umano e macchina.

Occorre perciò, oggi più che mai, rivalutare e riconsiderare con grande attenzione il rapporto tra essere umano e macchina. È tempo di esaminare da vicino le conseguenze sociali del processo decisionale algoritmico e chiederci come possiamo garantire che la tecnologia venga utilizzata al servizio della società.

La Bertelsmann Stiftung è una fondazione indipendente con sede in Gütersloh (Germania) che si occupa di promuovere “processi di riforma” e “principi dell’attività imprenditoriale” per costruire una “società orientata al futuro”. La fondazione si è resa recentemente soggetto propositivo di un’iniziativa interdisciplinare rivolta a tutti coloro che influenzano in modo significativo la creazione, lo sviluppo, la programmazione, l’implementazione o gli effetti di un sistema algoritmico. Le risultanze degli algoritmi sono influenzate – infatti – non solo dai loro codici di programmazione, ma soprattutto dai loro obiettivi, dal contesto organizzativo e dai modi in cui i risultati di un sistema vengono presentati, interpretati e applicati.

La fondazione Bertelsmann Stiftung ha perciò proposto le “AlgoRules“, un serie di 9 punti da considerare nello sviluppo di tutti quegli algoritmi che forniscono un significativo impatto sulla vita delle persone o sulla società. Oggi gli algoritmi decidono sulla partecipazione delle persone nella società: la concessione di un prestito, l’ammissione alle università, l’assunzione nei posti di lavoro; spetta a noi decidere se tali scelte automatizzate portino a maggiori pari opportunità o aumentino la disuguaglianza sociale. Ecco perché dobbiamo garantire che le nostre interazioni con gli algoritmi seguano un punto di riferimento inequivocabile: le macchine devono servire la società. Al contrario, sono invece oggi più che mai frequenti nuovi condizionamenti che portano l’essere umano ad adattarsi alle scelte e alle imposizioni fornite dagli algoritmi così da stravolgere il rapporto uomo-tecnica come già citato da Galimberti.

Quando gli algoritmi traggono conclusioni dai dati che elaborano utilizzando statistiche inferenziali o tecniche di apprendimento automatico, producono conoscenze probabili ma inevitabilmente incerte o preconcette. Il progetto e la funzionalità di un algoritmo riflettono i valori e i pregiudizi del suo progettista, se non altro nella misura in cui un particolare progetto è preferito come l’opzione migliore o più efficiente. Lo sviluppo non è un percorso lineare e neutro; non c’è una scelta oggettivamente corretta in un dato stadio di sviluppo, ma molte scelte possibili. Di conseguenza, “i valori dell’autore [di un algoritmo], consapevolmente o meno, vengono congelati nel codice, istituzionalizzando efficacemente quei valori”, come riportano Friedman and Nissenbaum nel saggio “The ethics of algorithms: Mapping the debate” (Big Data & Society, 2016).

Quando gli algoritmi traggono conclusioni dai dati che elaborano utilizzando statistiche inferenziali o tecniche di apprendimento automatico, producono conoscenze probabili ma inevitabilmente incerte o preconcette. Il progetto e la funzionalità di un algoritmo riflettono i valori e i pregiudizi del suo progettista, se non altro nella misura in cui un particolare progetto è preferito come l’opzione migliore o più efficiente. Lo sviluppo non è un percorso lineare e neutro; non c’è una scelta oggettivamente corretta in un dato stadio di sviluppo, ma molte scelte possibili. Di conseguenza, “i valori dell’autore [di un algoritmo], consapevolmente o meno, vengono congelati nel codice, istituzionalizzando efficacemente quei valori”, come riportano Friedman and Nissenbaum nel saggio “The ethics of algorithms: Mapping the debate” (Big Data & Society, 2016).

I pregiudizi sociali possono essere pertanto intenzionalmente incorporati nella progettazione del sistema, ad esempio negli aggiustamenti manuali degli indici dei motori di ricerca e dei criteri di classificazione. Tale pregiudizio sociale può anche essere involontario, un sottile riflesso di valori culturali o organizzativi più ampi, come ad esempio gli algoritmi di apprendimento automatico addestrati da dati con “etichette” imparano inavvertitamente a riflettere i pregiudizi della persona che ha inserito e selezionato tali criteri.

I pregiudizi sociali possono essere intenzionalmente incorporati nella progettazione del sistema.

Dice Paolo Benanti, professore ordinario di Etica della Tecnologia ed Etica dell’AI, membro del Gruppo di Esperti del Ministero dello Sviluppo Economico: “Non tutte le forme di progresso riflettono uno sviluppo“. Infatti, quando parliamo di progresso tecnologico parliamo di innovazione; quando usiamo il termine “sviluppo” ci riferiamo a un’innovazione diretta ai principi del bene comune. Man mano che vengono tracciati nuovi confini tra gli esseri umani e la tecnologia, occorre riflettere attentamente sul percorso verso il quale l’uomo viene trascinato dall’estrema dipendenza dal software. Poiché le decisioni umane vengono sostituite da quelle algoritmiche e diventiamo strumenti le cui vite sono modellate dalle macchine e dalle loro conseguenze non intenzionali, ci stiamo preparando per il dominio tecnologico.

Dobbiamo decidere, finché possiamo, cosa questo significhi per noi, sia come individui che come società. Gli algoritmi possono togliere dalla nostra giurisdizione molte scelte difficili e strategiche, se glielo permettiamo.

Esisterà ancora posto per il giudizio umano?