Le ambigue manipolazioni della rivoluzione digitale

Mentre facciamo shopping, mentre ci spostiamo, telefoniamo, operiamo in banca, siamo continuamente connessi e tracciati, molto spesso a nostra insaputa, sotto l’ombrello della sicurezza nazionale, dell’efficienza bancaria, della velocità di transazioni commerciali. Tutto ciò produce enormi tracce di dati che consentono di ricostruire ciò che accade nel mondo e capire cosa stia succedendo in ogni preciso istante: il Big Data. Ogni 60 secondi vengono prodotte 700mila interrogazioni di Google e sono pubblicati 500mila post su Facebook.

Sembrerebbe quindi possibile che – dall’analisi di questo oceano di numeri in tempo reale – si possano costruire nuovi strumenti per esplorare il mondo e vedere perciò cosa è sbagliato, dove il sistema non funziona e sperare di correggerlo. Nel 2016 un nutrito gruppo di persone ha sostenuto la possibilità di eleggere Watson – il sistema di intelligenza artificiale prodotto da IBM – a Presidente degli Stati Uniti, ma sempre nello stesso anno, Tay – il “chatbot” di Microsoft che avrebbe dovuto interagire autonomamente su piattaforme social – dopo un breve ha iniziato a comporre frasi neo-naziste e sessualmente offensive.

L’affidamento di decisioni al Big Data contiene diverse insidie, ma la più evidente è questa: all’aumento della quantità di dati, aumenta con la stessa velocità anche la quantità di modelli (pattern) di correlazione fra i dati stessi, ma spesso si tratta di correlazioni spurie ed errate che generano confusione nell’analisi e difficoltà nella loro discriminazione. Rapportando questo fenomeno alla vita quotidiana, è come quando si guarda in cielo e si crede di vedere nelle formazioni nuvolose oggetti, volti, animali: questi modelli non hanno alcun significato nella realtà e rappresentano solo una correlazione di fantasia. Lo stesso rischioso fenomeno si presenta nell’analisi dei dati (es: la quantità di consumo di cioccolato e il numero di serial killer sembrano essere correlati, ma in realtà non esiste alcun rapporto causale, è uno schema spurio senza significato).

Dati di qualunque tipo si sovrappongono e quindi si verificano errori: allarmi che devono attivarsi non si attivano oppure viceversa, in ogni settore. Si è visto che, nel caso dei maggiori attacchi terroristici, i colpevoli erano già da tempo noti alle forze di Polizia, ma nonostante ciò questo non ha potuto prevenire l’azione violenta. D’altro canto, ci sono molti sospetti su quelle liste e accade anche che persone senza alcuna reale tendenza al terrorismo possano finire in quell’elenco solo perché l’algoritmo le ha definite tali sulla base di un modello comportamentale errato. A tale scopo, risulta molto interessante lo studio di John Ioannidis dal titolo “Why Most Published Research Findings Are False”.

La potenza di calcolo disponibile è in continuo, esponenziale aumento; è la Legge di Moore, raddoppia ogni 18 mesi e c’è già chi si aspetta che in pochi anni i computer supereranno le capacità degli esseri umani. In verità, ciò è già avvenuto per singole e specifiche applicazioni: il computer sicuramente supera l’essere umano in quanto a capacità di calcolo, velocità e precisione nello svolgere un dettagliato compito e tutto ciò – fino a questo momento – rappresenta un ausilio per le attività quotidiane dell’uomo. Sembra addirittura che IBM Watson sia in grado di fornire una diagnosi clinica migliore e più rapida di molti medici, oltre ad avere la capacità di rispondere a molte domande complesse. Certamente – però – a tutte quelle domande che già dispongono di una risposta.

Nell’articolo “Big Data: porre le giuste domande” avevamo già evidenziato come la caratteristica più sorprendente che si rileva nel fenomeno del Big Data, è che proprio a causa della dimensione e della destrutturazione dei dati, l’informazione non esiste fintantoché non viene formulata la domanda. Quindi il problema oggi diviene: come formulare la giusta domanda a una collezione Big Data? La domanda è molto più decisiva di tutte le possibili risposte.

Era inevitabile che, con questa illusione dell’enorme massa di dati disponibile, a qualcuno venisse in mente di tentare di realizzare una società completamente governata da macchine, nel migliore stile cinematografico, ed è esattamente quello che alcuni paesi, fra cui Singapore, stanno cercando di fare. Fondamentalmente, vengono usati algoritmi di “deep learning” per capire cosa sta facendo la popolazione, perché lo fa e come sia possibile indirizzare la volontà sulla base di tutti i dati raccolti per ciascun abitante.

Nell’economia del mondo accelerato in cui viviamo, ognuno di noi è bombardato con una massa incontrollabile di informazioni, molte più di quante siamo effettivamente in grado di gestire con consapevolezza. Ciò genera una sorta di “sbornia” informativa che come risultato porta alla rinuncia dello spirito critico personale (che richiederebbe tempo per riflettere) e a una pericolosa vulnerabilità. In questi casi, infatti, è più facile che le persone adottino le decisioni che vengono loro “raccomandate”, più semplici da prendere in quanto risolvono un problema di angoscia generato dalla bulimia informativa.

Nell’economia del mondo accelerato in cui viviamo, ognuno di noi è bombardato con una massa incontrollabile di informazioni, molte più di quante siamo effettivamente in grado di gestire con consapevolezza. Ciò genera una sorta di “sbornia” informativa che come risultato porta alla rinuncia dello spirito critico personale (che richiederebbe tempo per riflettere) e a una pericolosa vulnerabilità. In questi casi, infatti, è più facile che le persone adottino le decisioni che vengono loro “raccomandate”, più semplici da prendere in quanto risolvono un problema di angoscia generato dalla bulimia informativa.

Queste informazioni “personalizzate” contengono suggerimenti (commerciali, politici, economici) che ben si adattano alle nostre personalità digitali tanto da pensare che sarebbero state proprio le scelte giuste da prendere! L’utente subisce questa manipolazione inconsapevolmente, senza nemmeno prendere coscienza di essere stato plagiato.

È evidente come una tale tecnologia abbia potuto far gola a Governi o a gruppi politici di varia natura. Si chiama “Nudging” (spingere, indurre) e in combinazione con il Big Data, il nome è diventato “Big Nudging“.

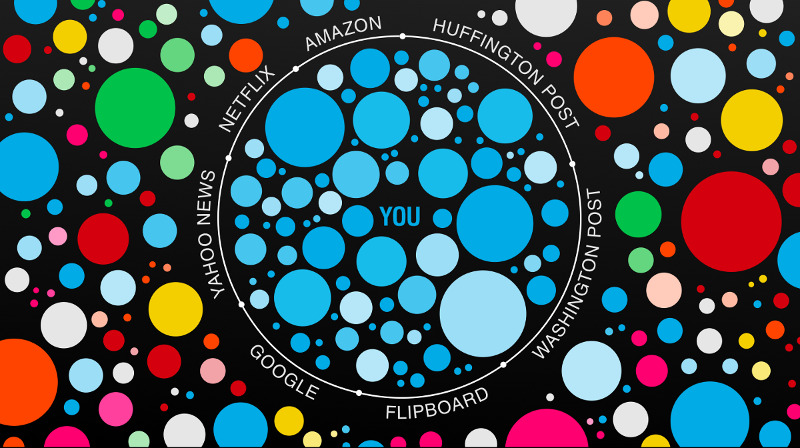

Lo psicologo comportamentale B.F. Skinner sperimentò, alcuni decenni fa, lo Skinner Box, una “Camera di condizionamento operativo” in cui venne provato come le cavie animali potessero essere condizionate nel comportamento attraverso due leve (una dava una scossa, e l’altra un pezzo di cibo). Non è difficile raffrontare lo Skinner Box con la manipolazione comportamentale che avviene oggi nell’Infosfera(termine coniato da Luciano Floridi per indicare lo spazio dell’informazione digitale). Aziende come Google e Facebook sono in costante esecuzione di esperimenti con gli utenti per cecare di capire come indirizzarli a scegliere certi collegamenti o ad acquistare determinati prodotti. Lo Skinner Box in cui viviamo è rappresentata dalla bolla digitale che viene creata attorno a ciascuno di noi, un cloud di informazioni personalizzate adattate ai nostri gusti, che indirizzano le nostre scelte e influenzano il modo di pensare e il nostro comportamento.

L’effetto più immediato di queste tecnologie è evidente: diventa sempre più difficile pensare autonomamente, fuori dagli schemi, limitando, fino ad annientare, la propria creatività e spirito critico. Vivendo in questa bolla filtrante, esiste la tendenza a produrre polarizzazione nella società: le persone perdono la capacità di confrontarsi con diversi tipi di opinioni, disgregando la coesione sociale a favore di una marcata tendenza a far convergere le opinioni su due gruppi contrapposti.

Tuttavia esistono strumenti di manipolazione ancora più potenti, come ad esempio il “Sistema di credito sociale” attualmente in corso di sperimentazione in Cina. Si tratta di un sistema a punteggio, in cui ogni cittadino guadagna o perde punti in accordo con le sue scelte o azioni. In altri termini, se viene cliccato un certo link di Internet, l’azione viene valutata: se l’opinione è in accordo con le linee governative, si guadagna un punto, altrimenti se ne perde uno. Acquisti, scelte, operazioni bancarie, tutto viene valutato al fine del punteggio totale il quale determinerà le condizioni per l’ottenimento di un prestito, per accedere a un determinato lavoro o per avere l’autorizzazione a viaggiare in certi Paesi.

È significativo osservare la ricerca della società Mercer sulle 10 città più “vivibili” del mondo (vedi figura): nella lista non compare nessuna città dei principali Paesi maggiori detentori della tecnologia IT/Big Data. Allora, se questa tecnologia non aiuta l’uomo a vivere meglio, non incrementa la condizione di vivibilità per gli esseri umani, qual è il suo scopo?

Secondo Dirk Helbing, professore di Scienze sociali computazionali presso il Dipartimento di Scienze umanistiche, sociali e politiche dell’Università ETH di Zurigo, “credo sia necessario garantire il controllo democratico di tali tecnologie, attraverso pareri scientifici e punti di vista interdisciplinari. Dobbiamo garantire l’uso etico, la trasparenza e la responsabilità. Ritengo che queste tecnologie possano veramente essere molto utili per l’umanità, se usate nel giusto modo. Ma saremo in grado di capire qual è il giusto modo?“.

Tutto ciò porta la nostra società verso un punto critico: ci troviamo a un bivio e occorre valutare con decisione e responsabilità la scelta che potrà determinare le sorti della nostra società nel futuro delle prossime generazioni. Il rischio è rappresentato dalla perdita di tutto ciò che è stato costruito in centinaia di anni, tra cui libertà, democrazia, giustizia e – soprattutto – la nostra “humanitas“.

Link di riferimento:

- Watson for President

- Why Microsoft Accidentally Unleashed a Neo-Nazi Sexbot

- Why Most Published Research Findings Are False

- Big Data: porre le giuste domande

- Frontiere etiche dell’intelligenza artificiale

- Big data meets Big Brother as China moves to rate its citizens

- Mercer Quality of Living Survey